St Michael’s parish Church, Ashton-Under-Lyne

© Copyright David Dixon and licensed for reuse under this Creative Commons Licence.

以前、Azure Prompt Flowについて実際に試用しながらブログでまとめていた時に、OpenAIが「Code Interpreter(=Advanced Data Analysis)」機能をリリースしたことが気になっていましたが、今回もTEチャレンジについてまとめながら、OpenAIが新たにリリースしたGPT-4Vの機能が気になっていました。

すでにご存じの方も多いと思いますが、GPT-4Vは、画像解析機能を持つChatGPTの最新バージョンです。GPT-4Vは、アップロードされた画像を認識し、それに関連するタスクを実行できます。例えば、画像からテキストやコードを生成したり、画像に対する質問に答えたり、画像を改善したりすることができます。GPT-4Vは、GPT-4の強力な自然言語処理能力と、最先端の画像処理技術を組み合わせています。GPT-4Vは、ChatGPT Plusのユーザーに限定されている機能です。

なお、GPT-4Vの「V」は、Visionの略で、画像解析機能を持つChatGPTの最新バージョンであることから、この名前が付けられました。

※以上は、BingによるGPT-4Vの説明でした。

すでに、いろいろなところでGPT-4Vに関する情報は提供されています。例えば:

- 2023年10月5日:GPT-4V: 驚きを隠せない進化!凄すぎて”ズキズキワクワク”が止まりません!!!

- この機能は、ChatGPT開始時に(Browse with Bing、Advanced Data AnalysisやPluginsではなく)GPT-4のDefaultにチェックを入れれば使えるようになる。

- 画像ファイルを入力するには、プロンプト欄に表示されたアイコンをクリックする。

- 機能の活用事例としては、四則演算ができる単純な電卓の画面ファイルを入力し、『あなたは、HTML, CSS, Javascriptのスペシャリストです。この電卓プログラムを再現してください』とプロンプトから指示するだけで、Web画面上で計算することができるHTML + CSS + JavaScriptが出来上がる。

- 2023年10月5日:【GPT-4V】ChatGPTが人間を超越する。究極の使い方10選

- 【ソフトウェア開発の活用事例】サンプル画像からSaaSのHTMLコードを生成

- 【コーディングの活用事例】計算機アプリのスクショからそのサンプルコードを生成

- 【状況推理の活用事例】道頓堀の写真から2023年の阪神優勝を推定

- 【Web開発の活用事例】原案の絵からWebサイトのHTMLコードを生成

- 【翻訳の活用事例】古文書のアラビア語を英語に翻訳

- 【eラーニングでの活用事例】ニューラルネットワークの概念図から内容を詳しく解説

- 【創作活動での活用事例】絵を上手く描くアドバイスが可能

- 【受験勉強での活用事例】高校数学の図形問題に正解

- 【資料収集の活用事例】色分けした日本地図から色分けの基準を推定

- 【UIテストの活用事例】ゲームのスクショから改善できる点を提案

- 2023年19月5日:GPT-4Vの性能テストと様々な活用方法

- 画像の理解(例:ジブリの「千と千尋の神隠し」の画像認識)

- 図表の理解(例:日本の人口ピラミッドの経年変化の理解)

- 日本の大学共通テストの問題のイメージ画像から問題を解かせる

- 2023年10月6日:ChatGPTの新機能『GPT-4V』とは?使い方と活用方法を解説!

- PCのブラウザと(iPhoneの)アプリでの画像入力方法と、画面認識精度

- アプリ版での音声入力するための設定を含めた操作方法

- PCのブラウザで音声入力したい場合のプラグインの説明

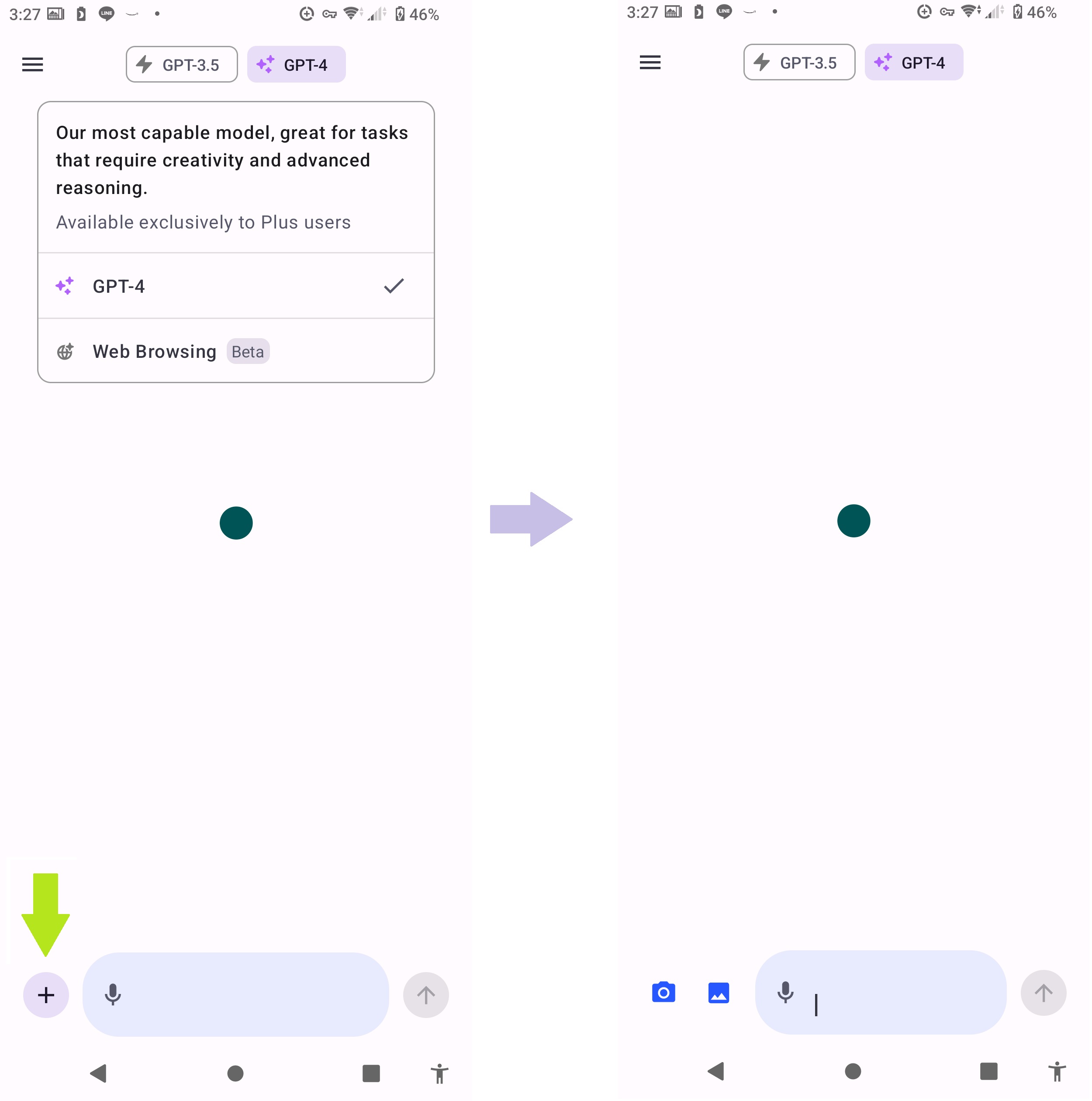

なので、GPT-4Vを使いはじめるにあたってほとんど補足する必要はないのですが、4番目の解説の中のChatGPTアプリの画面イメージは、iPhone版のアプリのもののようなので、Android版のChatGPTアプリの画面イメージを以下に掲載します。

アンドロイドのChatGPTアプリを立ち上げると、左側の画面のような感じなので、Web Browsing Betaではなく、GPT-4を選び、次に、画面左端の⊕アイコンをクリックすると、右側のスクリーンショットのように、⊕アイコン部分が、写真を撮ってGPT-4Eに渡す場合のカメラのアイコンと、すでにスマホ内に保持する画像ファイルをGPT-4に渡す場合のフォルダのアイコンに置き換わります。

ChatGPTアプリの場合、音声入力のマイクのアイコンは、GPT-4V以前からプロンプト欄の中に表示されていました。

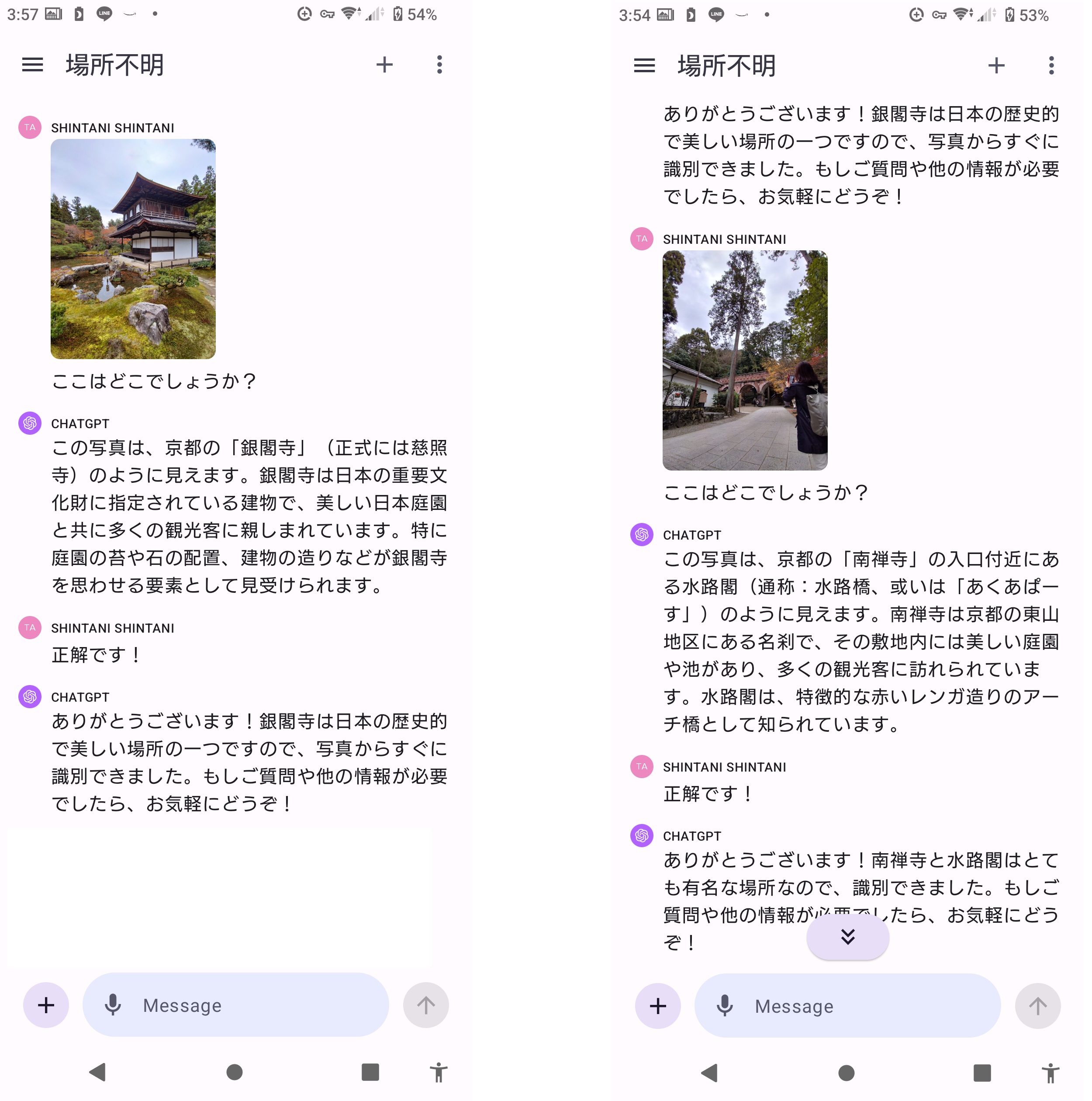

以下は、非常に単純な活用例ですが、スマホのフォルダからいくつか京都の写真をアップしてGPT-4Vに場所を特定してもらったものです。

有名な観光都市の写真をアップすると、このように見事に場所を特定してくれましたが、流石に地元の公園の写真に関しては、「申し訳ございませんが、この画像だけでは具体的な場所を特定するのは難しいです。」との返答でした。

なお、人の顔が特定できる写真をアップした場合、「Sorry, I cannot help with that.」との回答だったので、「なぜですか?」と聞いたところ、「申し訳ございません。お送りいただいた画像には実際の人物が写っており、リアルな人物に関する物語や詳細を想像して提供することは控えております。安全な情報提供を目指しており、プライバシーと感受性の問題に配慮しています。何か他の質問やリクエストがあればお知らせください。」とのことでした。

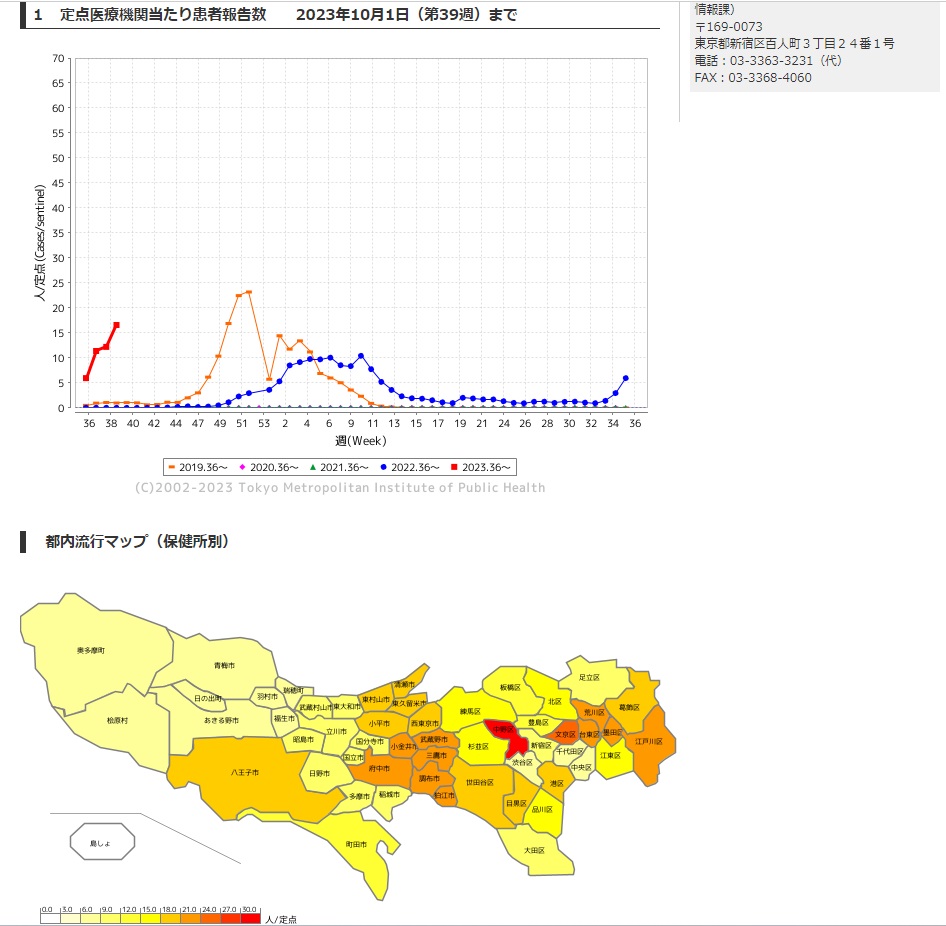

次に、GPT-4Vが、もう少し踏み込んだ画像認識ができるかどうか次の画像で試してみました。

私#1:

この画像から読み取れることを解説してください。

ChatGPT GPT-4V#1:

画像から読み取れる情報を以下にまとめて説明いたします。

タイトルと日付:

画像の上部に「手足口病患者発生動態」というタイトルがあり、これは手足口病の患者の発生状況に関するデータであることを示しています。

2023年10月1日(第39週)の情報を基にしているようです。

グラフ:

Y軸は「症例数(症例/週)」を示しており、X軸は週を表しています。

4つの異なる年(2019、2020、2021、2022、2023)のデータが含まれているようです。

2023年のデータは、先週までの週数に基づいています。

一部の週には症例数が急増していることが確認できます。

地図:

東京都の各区を示す地図があります。

地図上の各エリアは色分けされており、それぞれの色は手足口病の発生状況を示すものと思われます。

特定のエリア(赤くマークされている部分)は、症例が特に多いことを示している可能性があります。

著作権情報:

画像の下部に「(C)2002-2023 Tokyo Metropolitan Institute of Public Health」という著作権情報が記載されています。

以上の情報から、この画像は東京都内の手足口病の患者の発生状況を示すもので、特定のエリアや週における症例数の変動を確認することができると言えます。

私#2:

惜しいですね。画像上端の文字は「1 定点医療機関当たり患者報告数」で手足口病患者のデータではありません。ただし、他の部分についてはその通りです。

ChatGPT GPT-4V#2:

申し訳ございません、その点を見落としてしまいました。「1 定点医療機関当たり患者報告数」は、特定の定点医療機関ごとに報告される患者数を示すもので、手足口病患者専用のデータではないことが理解できます。

ご指摘いただき、ありがとうございます。正確な情報を提供するためのフィードバックは大変有益です。

私#3:

画像最下段に白から黄色、オレンジ色、赤に変化するバーが表示されていて、それぞれの色の上に数値があり、バーの右横に「人/定点」と書かれていますが、その部分の解釈についてお願いすます。

ChatGPT GPT-4V#3:

画像の最下段に表示されている色分けされたバーは、地図の色分けと連動していると考えられます。このバーは、各区やエリアの「定点医療機関当たりの患者報告数」を示すカラーコードを表していると思われます。

「人/定点」という表記は、1つの定点医療機関あたりの患者数を示していると解釈されます。したがって、各色に付随する数値は、その色が示す患者数の範囲を示しています。例えば、白色が0人、淡い黄色が1人、濃い黄色が2人…といった具体的な患者数を示すカラーコードが、バーによって示されていると考えられます。

具体的な数値を確認するには、画像を拡大する必要があるかもしれませんが、これにより地図上の各エリアの患者数を色で一目で確認することができます。

私#4:

では、地図上の区および市町村名と対応させて、患者報告数の最も多いところと、少ないところを教えてください。

ChatGPT GPT-4V#4:

画像から読み取ることができる情報に基づいて、以下の解釈を行います。

患者報告数の最も多いところ:

色が最も濃い(赤色に近い)エリアは患者報告数が最も多いところを示しています。

この画像において、中央区が赤色に近く、患者報告数が最も多いと考えられます。

患者報告数の最も少ないところ:

色が最も薄い(白色に近い)エリアは患者報告数が最も少ないところを示しています。

この画像において、大田区、練馬区、世田谷区、杉並区など、いくつかの区が白色または淡い黄色で示されており、これらの区は患者報告数が最も少ないと考えられます。

ただし、正確な数値や具体的なランキングを提供するには、より詳しいデータや情報が必要です。上記の解釈は、提供された画像からの視覚的な評価に基づいています。

私#5:

地図上の文字が小さすぎて読み違えたのかもしれませんが、患者報告数が最も多いのは中央区でなくて中野区ですね。また、私が見る限り淡い黄色の区・市町村は、奥多摩地区など東京都の西方にもっと多くある気がします。

ChatGPT GPT-4V#5:

申し訳ございません、画像の読み取りにミスがありました。再度確認させていただきます。

患者報告数の最も多いところ: 中野区が赤色に近く、患者報告数が最も多いと考えられます。

患者報告数の最も少ないところ: 奥多摩地区や東京都の西方に位置する一部の市町村や区が淡い黄色で示されており、これらの地域は患者報告数が最も少ないと考えられます。

ご指摘いただき、ありがとうございます。再度、画像を参照しながら正確に情報を提供するよう努めます。

私#6:

渋谷区、千代田区、文京区も淡い黄色に見えますが、いかがでしょうか?

ChatGPT GPT-4V#6:

おっしゃるとおり、渋谷区、千代田区、文京区も淡い黄色に見えます。これは、これらの区の「定点医療機関当たりの患者報告数」が低いことを示しています。

したがって、渋谷区、千代田区、文京区も患者報告数が比較的少ない地域であると解釈できます。おっしゃるとおりの観察をありがとうございます。

私#7:

グラフの情報で、2023年について何か言えることがありませんか?

ChatGPT GPT-4V#7:

提供されたグラフをもとに、2023年の情報に関する解釈を行います。

2023年の傾向: グラフを見ると、2023年(2023-36wからのデータ点)における患者報告数は増加傾向にあるようです。初めの数週間では比較的低かった報告数が、最近の週にかけて急激に増加しています。

比較: 2023年の増加傾向は、2021年や2020年の同じ時期と比べると非常に顕著です。2020年と2021年は、この時期にピークを迎えていましたが、2023年はさらに患者数が増加しているようです。

現在の状況: 最も最近のデータポイント(2023年の後半)を見ると、患者報告数は非常に高い状態となっています。これは、この病気や状態が現在流行している可能性を示唆しています。

これらの解釈は、提供されたグラフの情報のみに基づいています。具体的な病気や状態、またその背景や原因などについての詳しい情報は、このグラフからは読み取れません。

という感じで、現状では、単に画像の精度が悪くて文字認識が落ちただけではなく、地図の情報の細かな部分を認識するのは、まだあまり得意ではない感じがしました。

また、今回試してみませんでしたが、よく似た画像を見せて、違いを発見させるような問題をGPT-4Vは苦手としているようです。

3番目の「GPT-4Vの性能テストと様々な活用方法」の4.間違い探し「(1) サイゼリヤの間違い探し」をご覧ください。

本日は、とりあえず、「GPT-4V」に関して触ってみた感想をまとめました。

後半、否定的な表現が多くなってしまいましたが、「Advanced Data Analysis」の機能同様、今後「ITリテラシ」の代表的なツールに早くなってほしいが故の辛口コメントですので、そのようにご理解ください。

なお、GPT-4Vと並行して、GPT-Plusユーザは、自然言語による画像生成AIであるDALLの最新版DALL-E3が使えるようになるようです。すでに使えるようになっているユーザもいるようですが、私のChatGPTではまだ使えないようなので、使えるようになった時点で、どんな感じかレポートしたいと思います。

終わり