The Central Lowlands from Philpstoun shale bing

© Copyright AlastairG and licensed for reuse under this Creative Commons Licence.

ITmedia NEWSの記事によると、経済産業省と総務省は、1月19日に、生成AIの普及を踏まえてとりまとめた「AI事業者ガイドライン案」のパブリックコメントの募集を始めると発表。1月20日から2月19日まで、行政情報の総合窓口サイト「e-Gov」で募集しています。

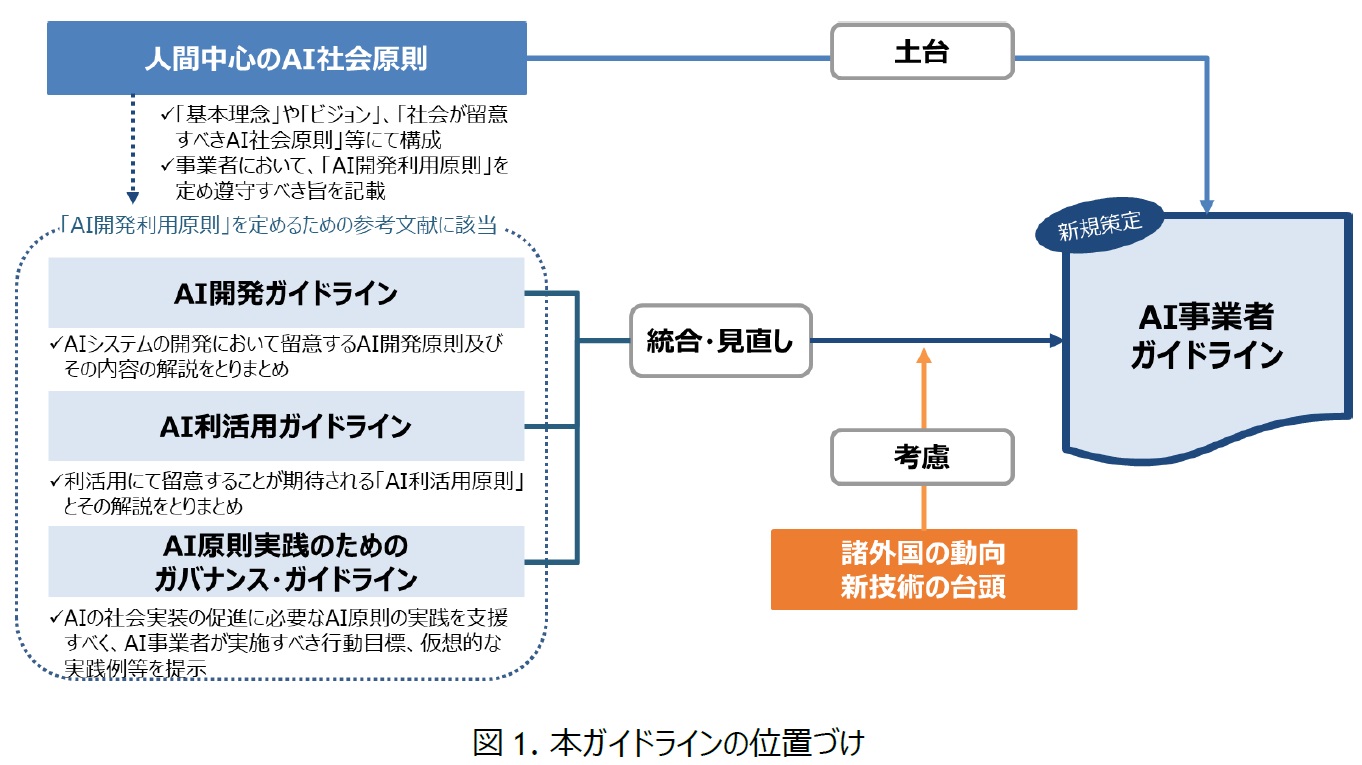

これは、内閣府が昨年5月に開催した「AI戦略会議」で出た「生成AIが与える社会への影響を踏まえ、既存のガイドラインの改定を検討するべき」という意見に基づき、下図の通り、既存のAI関連ガイドラインを統合・アップデートし、AI事業者向けのガイドラインの検討を進めてきたもので、ガイドラインでは「AIは利用形態によっては、社会に対して大きなリスクを生じさせ、そのリスクに伴う社会的なあつれきにより、AIの利活用自体が阻害される可能性がある」と指摘。過度な対策で便益を阻害しないためにも、企業が取るべき対応などが示されているようです。

今回は、ChatGPT-4に、このAI事業者ガイドライン案を見せ、コメントしてもらったので、その経緯をご紹介します。

私#1:

経済産業省と総務省が、生成AIの普及を踏まえてとりまとめた「AI事業者ガイドライン案」のパブリックコメントを募集しているので、意見をまとめるのを手伝ってください。

ChatGPT-4#1:

経済産業省と総務省は、生成AIの普及を踏まえた「AI事業者ガイドライン案」の意見募集を行っています。このガイドライン案は、AIの安全で安心な活用を促進し、我が国におけるAIガバナンスの統一的な指針を示し、イノベーションの促進と連鎖リスクの緩和を目的としています。

ガイドラインは、企業、政府・自治体、教育機関、NPO・NGOなど、AIを活用するさまざまな組織に向けて作成されています。AIの進化とその活用が急速に進む中で、業務の効率化やイノベーションの加速、社会的課題の解決にAIが貢献することが期待されています。しかし、AIの利用拡大には、特有のリスクも伴います。そのため、これらのリスクを緩和し、安全で安心なAIの利用を促進するためのガイドラインが必要とされています。

意見募集の期間は2024年1月20日から2月19日までです。意見は、電子政府の総合窓口(e-Gov)を通じて提出できます。提出された意見は、公表される場合がありますが、個別の回答は行われない点に留意する必要があります。

このガイドライン案の策定背景には、AI技術の日々の進化と、それに伴う利用機会の増加が挙げられます。政府は「Society 5.0」を掲げ、経済発展と社会的課題の解決を両立する人間中心の社会の実現を目指しており、その実現にはAIの高度な活用が不可欠です。

これまでにも、AI開発ガイドラインやAI利活用ガイドラインなど、複数のガイドラインが策定されてきましたが、技術トレンドの変化に伴う統合・見直しが行われ、今回のガイドライン案が策定されました。このガイドラインを通じて、AIを活用する事業者は、安全で安心なAI活用のための望ましい行動指針を確認できるようになります。

意見をまとめる際には、これらの背景や目的を踏まえ、AIの安全な利用とイノベーション促進にどのように寄与するか、また、連鎖リスクの緩和について具体的な提案を行うことが重要です。また、ガイドラインが多様な組織にとって実用的かつ理解しやすい形であること、最新の技術トレンドや社会的ニーズに応える内容であることも、重要なポイントとなるでしょう。

パブリックコメント対象の「AI事業者ガイドライン案」は、本編と別添で構成されており、それぞれ異なる内容に焦点を当てています。本編では、AI事業者に対するガイダンスの「なぜ(Why)」と「何を(What)」に関する指針を提供しています。これは、AIの利用における目的、目指すべき方向性、及び遵守すべき基本原則など、ガイドラインの基礎的な理念や目的を説明する部分です。

一方、別添では「どのように(How)」を扱い、AI事業者がガイドラインの指針に沿って実際に何をすべきか、どのように取り組むべきかについての具体的なガイダンスを提供します。これには、AI技術の適用方法、リスク管理のアプローチ、倫理的考慮事項への対応など、実践的なアドバイスや手順が含まれることが予想されます。

このように、ガイドライン案は、AI事業者がAI技術を効果的かつ責任ある方法で利用するために必要な、理論的及び実践的な知識の両方を提供することを目的としています。パブリックコメントを通じて提供される意見は、これらのガイドラインが現実のビジネス環境や技術的挑戦にどのように適用可能か、さらにはそれらを改善するためにどのような要素が必要かを反映する機会を提供します。

コメントを提出する際には、本編の指針が提供する「なぜ」と「何を」に加えて、別添が示す「どのように」に対する具体的なフィードバックや提案を含めることが有効です。これにより、ガイドラインがより実用的で適用しやすいものとなり、AI事業者が直面する実際の課題やニーズに応えることができるようになります。

私#2:

本編は第1部から第5部から構成されていて、別添も本編の構成に対応しているようですね。

ChatGPT-4#2:

はい、その通りです。本編と別添の構成が互いに対応しているということは、ガイドライン案が体系的に設計されており、AI事業者がガイドラインの各部分をどのように理解し、実践に移すべきかについて、明確なガイドを提供していることを意味します。

本編が「なぜ(Why)」「何を(What)」に焦点を当てるのに対し、別添はそれぞれのセクションにおける「どのように(How)」を詳述しています。これにより、AI事業者は理論的な指針と実践的なガイダンスの両方を、具体的な活動や決定に結びつけやすくなります。

たとえば、本編で述べられる倫理的原則や運用の枠組みがある場合、別添ではそれらの原則を実際の業務プロセスや意思決定にどのように組み込むか、具体的なアクションやチェックリストを提供することが期待されます。このような構成は、AI事業者にとって、理論から実践への移行をスムーズにし、AI技術の責任ある利用を実現するための実用的な支援となります。

ガイドライン案の詳細な内容については、総務省や経済産業省の公式サイト、またはe-Govのパブリックコメントページで提供されている資料を参照することが重要です。これらの資料を通じて、本編と別添の具体的な内容や、各部分がどのように互いに関連しているかについて、より深く理解することができます。

私#3:

したがって、パブリックコメントを検討・作成するにあたって、本編と別添を個別にみるのではなく、第1部から第5部それぞれの、本編と別添該当部分を合わせてみて、記述内容に矛盾がないのかを含めて検討したいと思います。

ChatGPT-4#3:

パブリックコメントを検討・作成する際に、本編と別添を合わせて総合的に見るアプローチは非常に効果的です。第1部から第5部にわたって、それぞれのセクションで提供される理論的指針(WhyとWhat)と実践的ガイダンス(How)が一貫性を持っているか、また、記述内容に矛盾がないかを検討することは、ガイドラインの品質を高める上で重要です。

このプロセスでは、以下のステップが考えられます:

- 各部の目的と内容の理解:まず、本編の各部が提供するガイダンスの目的と内容を理解します。これには、AIの利用に関連する倫理的原則、ガバナンス構造、リスク管理、技術の適用方法などが含まれる可能性があります。

- 別添との対応関係の確認:次に、本編の各部に対応する別添のセクションを詳細に確認し、実践的なガイダンスが本編の理論的指針とどのように連携しているかを検討します。具体的なアクションプラン、チェックリスト、事例研究などが本編の指針を補完し、実際の業務プロセスや意思決定にどのように応用できるかを理解します。

- 一貫性と矛盾の検証:本編と別添の内容が一貫性を持ち、相互に補完的であることを確認します。記述内容に矛盾がないか、また、提供されるガイダンスが現実の業務や技術的挑戦に対して実用的かつ適切であるかを検討します。

- 意見のまとめ:上記の検討を踏まえ、ガイドラインの改善や補強が必要と思われる部分についての具体的な意見や提案をまとめます。この際、ガイドラインがさらに実践的で理解しやすいものになるような提案が有効です。

- 意見提出:検討した意見をパブリックコメントとして提出します。提出方法は、e-Govのパブリックコメントページなど、指定された方法に従って行います。

このアプローチを通じて、AI事業者ガイドライン案がより包括的で実践的なものになり、AI技術の責任ある利用を促進することに貢献できるでしょう。パブリックコメントは、政策形成過程における重要な一歩であり、広範なステークホルダーからのフィードバックを通じて、より効果的なガイドラインの策定につながります。

私#4:

では、まず本編の第1部と別添の該当する部分をアップします。

ChatGPT-4#4:

I’m ready to assist you with reviewing the content of the first part of the main document and the corresponding section in the annex. Please upload the documents or provide the specific details you’d like to discuss or analyze.

私#5:

<本編第1部および別添第1部のpdfをアップロード>

本編第1部と、別添第1部の資料をアップしたので、①まず、それぞれの内容を要約し、②本編と別添資料の対応関係を確認し、③両者の資料の一貫性と矛盾の検証を行い、④ChatGPTのような生成AIの観点から、2つの資料に関して加筆・訂正すべき点があれば、該当箇所を指摘の上、意見をまとめ、回答を、①、②、③、④のタスクに分けて日本語で示してください。

ChatGPT-4#5:

了解しました。それでは、ご依頼に基づいて、各タスクを分けて回答します。

① 本編第1部と別添第1部の内容要約

- 本編第1部では、AIの進化の歴史を概観し、専門家システムから機械学習、ディープラーニングへの技術の進化、そして最近の生成AIの出現に至るまでを説明しています。AIシステム、AIモデル、AIサービスなどの定義や、AIガバナンスの重要性について触れています。

- 別添第1部では、AIシステムの具体的な適用例とそれらが社会にもたらす利益とリスクについて詳細に説明しています。AIのビジネスオペレーターのパターンやデータプロバイダーの役割についても触れ、実際のケーススタディを通じて、AI技術の適用方法とその影響を示しています。

② 本編と別添資料の対応関係の確認

- 本編と別添は互いに補完し合う関係にあります。本編がAIの理論的枠組みやガイダンスの「なぜ」と「何を」に焦点を当てているのに対し、別添ではそれらの実践的な「どのように」を具体的な例やケーススタディを通じて提供しています。

③ 両者の資料の一貫性と矛盾の検証

- 本編と別添は一貫性を保ちつつも、それぞれが異なる側面からAIの利用について照らし合わせています。本編がAIに関する基本的な理解とガバナンスの枠組みを設定するのに対し、別添はこれらの理解を実際のビジネスや社会に応用する方法を示しています。内容の矛盾は見受けられず、両資料は相互に補完的な情報を提供していると評価できます。

④ ChatGPTのような生成AIの観点からの加筆・訂正すべき点

生成AIの進化とその応用範囲の拡大を踏まえると、以下の点が強調または加筆されるべきです:

- 倫理的使用と透明性:生成AIによるコンテンツ生成における倫理的考慮事項と透明性の重要性をさらに強調する必要があります。特に、偏見の軽減や誤情報の防止に向けたガイドラインを明確化することが求められます。

- リスク管理:生成AI独特のリスク、例えば、著作権侵害やプライバシーの懸念、偽情報の生成に対するより具体的なリスク管理策を提示することが望まれます。

- 持続可能な開発と利用:AI技術の持続可能な開発と利用に関するガイドラインを追加し、環境への影響や社会的責

私#6:

一貫性の観点でいうと、AIという言葉の意味する範囲が、本編と別添で異なっていて、別添では生成AI/機械学習に特化した記述になっている気がします。

ChatGPT-4#6:

一貫性に関するご指摘に基づき、本編と別添のAIに関する定義や範囲の違いについて検討することは重要です。確かに、本編ではAIの一般的な概念やその進化について述べられているのに対し、別添では生成AIや機械学習に特化した記述がなされている可能性があります。これは、本編がAIの広範な理解を提供するのに対し、別添がより現実の適用例や特定の技術に焦点を当てることで、具体的な指針や例示を提供しているためかもしれません。

この違いは、ガイドライン全体の一貫性に影響を与え、AIの理解やガイドラインの適用において混乱を招く可能性があります。したがって、AIの定義や範囲についての明確化、特に本編と別添で使用されている用語の統一や説明の追加が、ガイドラインをより一貫性のあるものにするために必要です。

生成AIや機械学習に特化した記述に関しては、これらの技術が現代のAI応用において特に重要であることを反映している可能性が高いです。しかし、ガイドライン全体として、AIの広範囲にわたる応用や影響を考慮に入れつつ、特定の技術に偏らない形で情報提供を行うことが望ましいでしょう。

私#7:

AIの定義を本編第1部に入れ、広範なAIの分野のうち、このガイドラインでは対象外とするものはどれか明らかにすることも必要ではないでしょうか? 例えば、極端な例かもしれませんが、カナ漢字変換ツールも、広い意味でNLP(自然言語処理)の「AIシステム」と言って良いと思いますが、カナ漢字変換システムの開発者、提供者、利用者は、このガイダンスの第3部から第5部に記載された内容を気にする必要はないように思われます。

ChatGPT-4#7:

AIの定義を明確にすることは、ガイドラインの適用範囲を正確に理解するために非常に重要です。特に、どのようなAIシステムがこのガイドラインの対象となるか、また対象外とするものは何かを具体的に示すことで、開発者や利用者が自身の関与するシステムやサービスがガイドラインの適用を受けるかどうかを明確に判断できるようになります。

カナ漢字変換ツールのような、比較的単純なNLPシステムも技術的には「AIシステム」と見なすことができますが、そのようなシステムの開発者や利用者がガイドラインのすべての部分を適用する必要があるわけではありません。このため、ガイドライン内でAIの定義を明確にし、対象となる技術やシステムの範囲を具体的に示すことは、混乱を避け、より効果的な適用を促進するために役立ちます。

具体的には、本編第1部において、AIシステムの範囲を定義し、その中で特に焦点を当てる技術や応用分野を明確にすると共に、ガイドラインの適用対象外とするシステムや条件を示すことが推奨されます。これにより、ガイドラインの透明性と実用性が向上し、各関係者が自身の役割や責任をより明確に理解できるようになります。

私#8:

どうもありがとう。他に、第1部の記述に関して何か意見はありませんか?

ChatGPT-4#8:

本編第1部の記述に関して、追加で提案する意見は、AIの社会的影響や倫理的考慮に関するセクションを強化することです。AI技術、特に生成AIがもたらす可能性のあるポジティブな影響とリスクを平衡良く扱い、それに対応するための倫理的ガイドラインやベストプラクティスを提案することで、利用者や開発者が責任あるAIの使用を促進するための具体的な指針を得られるようにすることが重要です。また、多様性、公平性、透明性、説明責任といったAI倫理の核心的な原則に基づく実践的なアプローチを取り入れることで、技術の進化と共に変わりゆく社会的課題への適応を促すことができます。

私#9:

それは、次の第2部に該当するかも知れませんね。では、次に本編第2部と別添の該当する部分をアップします。

ChatGPT-4#9:

Please go ahead and upload the documents for the second part of the main text and the corresponding section in the annex, and I’ll assist you with the review.

私#10:

<本編第2部および別添第2部のpdfをアップロード>

本編第2部と、別添第2部の資料をアップしたので、①まず、それぞれの内容を要約し、②本編と別添資料の対応関係を確認し、③両者の資料の一貫性と矛盾の検証を行い、④ChatGPTのような生成AIの観点から、2つの資料に関して加筆・訂正すべき点があれば、該当箇所を指摘の上、意見をまとめ、回答を、①、②、③、④のタスクに分けて日本語で示してください。

ChatGPT-4#10:

① 要約

- 本編第2部は、AIガバナンスの構築に関して、経営層の責任とAIのリスク管理の重要性を強調しています。AIガバナンスは、組織全体でのAIの責任ある使用を確実にするための枠組みとして機能します。リスクの識別、評価、軽減のプロセスが含まれ、組織がAI技術を倫理的に、かつ法的に適合させる方法についての指針を提供します。

- 別添第2部では、AIガバナンスの具体的な実践方法を提供しており、経営層のリーダーシップの下でAIリスクを管理するための行動目標、実践のポイント、及び実践例が詳述されています。リスク分析、ゴール設定、システムデザイン、運用、評価の各ステップにおける具体的なアクションが紹介され、AIの便益を最大化しリスクを管理するための方法論が示されています。

② 対応関係の確認

- 本編と別添は、AIガバナンスの構築に関する対応関係を持っており、本編が「なぜAIガバナンスが必要か」という理論的な背景と指針を提供するのに対し、別添では「どのようにAIガバナンスを構築するか」という実践的な方法を示しています。この対応関係は、理論と実践を繋ぐ形で一貫性を持たせています。

③ 一貫性と矛盾の検証

- 本編と別添は、AIガバナンスの構築という共通の目的に基づきつつ、異なる視点(理論的背景と具体的実践)からアプローチしているため、内容の一貫性は保たれています。しかし、本編で提供される指針の抽象度と、別添での具体的な実践方法との間で、読者によっては解釈に幅が生じる可能性があります。この点において、より明確なガイドラインの設定や、本編の指針と別添の実践方法との間でのより詳細な対応関係の説明が必要かもしれません。

④ 加筆・訂正すべき点

- AIの定義や対象範囲の明確化が本編第1部で提案されたように、第2部においてもAIガバナンスの対象となるAIシステムやサービスの種類、特に生成AIに特化したガイダンスの必要性に触れることが有益です。また、具体的な実践例を通じて、異なる業界や規模の組織におけるAIガバナンスの適用方法に関するさらなる詳細を加えることで、ガイドラインの適用性を高められます。

私#11:

先ほどの「AIの社会的影響や倫理的考慮に関するセクションを強化する」という観点から加筆・訂正が必要な部分はないですか?

ChatGPT-4#11:

「AIの社会的影響や倫理的考慮に関するセクションを強化する」という観点から、本編第2部と別添第2部の内容に加筆・訂正が必要な部分を検討すると、以下の点が考えられます:

- AIの倫理的使用に関するガイドラインの明確化:AI技術が社会に与える影響を考慮し、倫理的な使用のための明確な指針を提供することで、AIの責任ある利用を促進する必要があります。これには、偏見のないデータセットの使用、プライバシーの保護、透明性の高いAIシステムの開発などが含まれます。

- 社会的影響への配慮:AIシステムの開発、導入、使用に際して、その社会的影響を評価し、特に脆弱なグループへの影響を考慮することが重要です。これには、アクセシビリティや包摂性の向上、デジタルデバイドの縮小などが含まれる可能性があります。

- ステークホルダーとのコミュニケーション:AIの影響を理解し、適切に対応するためには、ステークホルダーとの透明性のあるコミュニケーションが不可欠です。利害関係者への教育、意見交換の場の提供、公開討論への参加などが推奨されます。

これらの加筆・訂正を行うことで、ガイドラインはAI技術の社会への積極的な貢献と、その潜在的なリスクから社会を保護するためのバランスをより良く提供できるようになります。

私#12:

本編第2部「C. 共通に指針」に、[4)プライバシーの保護」、「5)セキュリティの確保」、「8)教育・リテラシー」がすでにありますが、加筆するとしたら、この中に反映させればよいでしょうか?

ChatGPT-4#12:

はい、「C. 共通の指針」において、AIの社会的影響や倫理的考慮に関するセクションを強化するためには、既存の「4) プライバシーの保護」、「5) セキュリティの確保」、「8) 教育・リテラシー」のセクション内に加筆するのが適切です。これらのセクションにはすでにAIの責任ある使用に関する重要な要素が含まれていますが、以下のような内容の追加が考えられます:

- プライバシーの保護:AIシステムによるデータ収集と処理の透明性を高め、利用者が自らのデータに関してより良い制御を持てるような具体的なガイドラインを追加する。

- セキュリティの確保:AIシステムのセキュリティ対策に関する最新の技術や手法についての情報を更新し、特に生成AIに関連する新たなセキュリティリスクへの対応策を提案する。

- 教育・リテラシー:AIの倫理的使用に関する教育プログラムを充実させ、AIリテラシーの向上を通じて、社会全体での責任あるAIの利用を促進するための内容を強化する。

これらの加筆により、AIの社会的影響や倫理的考慮に関する理解を深め、AI技術の責任ある使用を推進するための具体的なアクションプランを提供することが期待されます。

私#13:

どうもありがとう。では、次に本編第3部と別添の該当する部分をアップします。

ChatGPT-4#13:

Please go ahead and upload the documents for the third part of the main text and the corresponding section in the annex, and I’ll assist you with the review.

私#14:

<本編第3部および別添第3部のpdfをアップロード>

本編第3部と、別添第3部の資料をアップしたので、①まず、それぞれの内容を要約し、②本編と別添資料の対応関係を確認し、③両者の資料の一貫性と矛盾の検証を行い、④ChatGPTのような生成AIの観点から、2つの資料に関して加筆・訂正すべき点があれば、該当箇所を指摘の上、意見をまとめ、回答を、①、②、③、④のタスクに分けて日本語で示してください。

ChatGPT-4#14:

① 要約

- 本編第3部では、AI開発者が開発プロセス全般において考慮すべき安全性、公平性、プライバシー保護、セキュリティ確保などの要素に焦点を当てています。具体的な行動指針やAI開発時のリスク管理方法が提示されています。

- 別添第3部は、本編第3部の内容に基づいて、AI開発者が実践すべき具体的な手法とアプローチについて詳細な解説を提供しています。データの適切な取り扱い、バイアスの管理、セキュリティ対策などが含まれています。

② 対応関係の確認

- 本編と別添資料は、AI開発者が直面する課題とそれに対処するための具体的なガイダンスを提供する点で直接的な対応関係にあります。本編が理論的・指針的なアドバイスを提供するのに対し、別添ではそれを実践するための具体的な方法を説明しています。

③ 一貫性と矛盾の検証

- 本編と別添の資料は、AI開発における理論と実践の間で一貫性を保っています。本編で提示された原則や指針が別添での実践的なアプローチとして具体化されており、矛盾する点は見受けられません。

④ 加筆・訂正すべき点

生成AIの観点から見て、本編と別添での内容は適切に連携しているものの、以下の点で加筆や明確化が有益かもしれません。

- 透明性と説明責任の強化:AIモデルの意思決定プロセスに関するより詳細なガイダンスを提供し、ユーザーがAIの判断をよりよく理解し信頼できるようにするための方法を提案することが重要です。

- 最新のAI技術への適応性:AI技術は急速に進化しており、特に生成AIにおける新たなリスクや倫理的課題に対処するためのガイドラインの更新や柔軟性の確保が必要です。

- 国際的な規範との整合性:AI開発における国際的なベストプラクティスや規範との整合性を確保するためのガイダンスを強化することで、グローバルな文脈でのAIの責任ある使用を促進します。

私#15:

本編第3部のどこにこれらの意見を反映させればよいですか?

ChatGPT-4#15:

提案した意見は、本編第3部の以下のセクションに反映させることが適切です:

- 透明性と説明責任の強化:「D-6) 検証可能性の確保」のセクションに加筆し、AIの判断プロセスにおける透明性とユーザーの理解を深めるための具体的な方法についてのガイダンスを提供します。

- 最新のAI技術への適応性:「D-5) 最新動向への留意」と「D-10)i. イノベーションの機会創造への貢献」に追加し、新たな技術的進歩やリスクに対応するための継続的な更新と柔軟性の重要性に触れます。

- 国際的な規範との整合性:「高度なAIシステムを開発する組織向けの広島プロセス国際行動規範」のセクションにおいて、国際的な規範やベストプラクティスとの整合性を確保するための具体的なアクションを示します。

これらの加筆は、AI開発における倫理的、社会的課題への対応を強化し、より責任あるAIの使用を促進するために役立ちます。

私#16:

生成AIに限ったことですが、AI開発者は、OpenAIがChatGPTに採用しているRLHFを用いて、人間の価値基準に沿うように、人間のフィードバックを使ってAI(言語)モデルを強化学習するべきといった記述も必要ではないでしょうか?

ChatGPT-4#16:

生成AIに関する開発プロセスにおいて、人間の価値基準に沿うようにモデルを調整する手法としてRLHF(Reinforcement Learning from Human Feedback)の採用を提案することは、確かに重要なアプローチです。RLHFは、人間のフィードバックを直接AI(特に言語モデル)の訓練に組み込むことで、より倫理的でバイアスの少ない、人間の価値観に合致した振る舞いをAIに学習させる方法です。

この記述を本編第3部に加える場合、特に「D-3)ii. AIモデルのアルゴリズム等に含まれるバイアスへの配慮」や「D-10)i. イノベーションの機会創造への貢献」のセクションに反映させることが適切でしょう。これにより、AI開発者がAIモデルを設計・調整する際に、倫理的なガイドラインとしてRLHFの利用を検討することの重要性を強調することができます。加えて、AIが社会的な価値観と調和し、信頼性と公平性を確保するための具体的な手法としてRLHFの採用を促すことにも繋がります。

私#17:

いわゆるハルシネーションは、「D-3)ii. AI モデルのアルゴリズム等に含まれるバイアスへの配慮」とはまた違うと思うのですが、「ハルシネーションの生成を抑制する」というのもAI開発時、AI 開発者にとって重要な事項ではないでしょうか?

ChatGPT-4#17:

はい、AI開発において「ハルシネーション(誤った情報や存在しない事実の生成)の生成を抑制する」ことは、特に言語モデルや生成AIにとって重要な事項です。ハルシネーションは、AIモデルが不正確な出力を生成することを指し、これを抑制することは、AIの信頼性と正確性を高める上で不可欠です。このような事項は、AI開発者にとって特に注意すべき点であり、AIモデルの設計や評価のプロセスにおいて、ハルシネーションを最小限に抑えるための手法やアプローチを検討し実装することが求められます。したがって、本編第3部においても、この点に関するガイダンスや推奨事項を明確にすることが有効と考えられます。

私#18:

これを追加するとしたら、D-2 iv)あたりでしょうか?

ChatGPT-4#18:

「ハルシネーションの生成を抑制する」というテーマを追加する場合、確かに「D-2 iv)安全性に関する検討」のセクションが適切な場所の一つとなり得ます。このセクションでは、AIシステムが人間の生命や身体、財産に与える影響を考慮した開発が求められているため、ハルシネーションによる潜在的なリスクや誤情報の拡散を防ぐための対策も、安全性の観点から重要な検討事項として含めることができます。AI開発者は、モデルのトレーニングや評価の過程でハルシネーションを検出し、抑制するための技術的手段やプロセスを確立する必要があるでしょう。

私#19:

では、次に本編第4部と別添の該当する部分をアップします。

ChatGPT-4#19:

I’m ready to assist with the next part of your request. Please upload the documents for the fourth part of the main text and the corresponding section in the annex, and I’ll help with the review.

私#20:

<本編第4部および別添第4部のpdfをアップロード>

本編第4部と、別添第4部の資料をアップしたので、①まず、それぞれの内容を要約し、②本編と別添資料の対応関係を確認し、③両者の資料の一貫性と矛盾の検証を行い、④ChatGPTのような生成AIの観点から、2つの資料に関して加筆・訂正すべき点があれば、該当箇所を指摘の上、意見をまとめ、回答を、①、②、③、④のタスクに分けて日本語で示してください。

ChatGPT-4#20:

① 要約

- 本編第4部ではAI提供者の役割と責任について述べています。AI提供者は、AIシステムやサービスを安全かつ適切に利用者に提供し、社会や経済成長への貢献とともに、リスク管理やバイアスへの配慮などの要素を考慮する必要があります。

- 別添第4部は、本編の内容に基づき、AI提供者に向けた具体的な手法やアプローチについて解説しています。リスク対策、プライバシー保護、セキュリティ対策など、AI提供者が取り組むべき具体的な事項を詳述しています。

② 対応関係の確認

- 本編第4部と別添第4部は、AI提供者の役割と責任に関連する内容において直接的な対応関係にあります。本編が理論的かつ概念的な指針を提供するのに対し、別添ではこれらの指針を実践するための具体的な手法を説明しています。

③ 一貫性と矛盾の検証

- 本編と別添資料は、AI提供者が直面する課題に対処するための一貫したアドバイスを提供しており、明確な矛盾は見受けられません。本編で提示された指針や考慮事項が、別添で具体的な実践方法として詳細に解説されています。

④ 加筆・訂正すべき点

生成AIの観点から見ると、AI提供者が取り組むべき事項には、AIの進化に伴う新たなリスクやチャレンジも含まれるため、以下の点について加筆や更新を検討すべきです:

- 進化するAI技術への適応性:AI技術の急速な進化に伴い、新たに出現するリスクや倫理的課題に対処するための指針の更新や追加。

- 敵対的攻撃への対策:特に生成AIに関連する敵対的攻撃やデータポイズニングなど、新たなセキュリティリスクへの対策に関する具体的なガイダンスの強化。

- 説明責任と透明性の促進:AIモデルの判断根拠の透明性を高めるための手法やプロセスに関する詳細なガイダンスの提供。

私#21:

具体的に、本編第4部のどこの個所をどのように加筆訂正すべきかを示してください。

ChatGPT-4#21:

加筆・訂正すべき個所としては、以下の提案が考えられます:

- 進化するAI技術への適応性:

- 加筆場所: 「P-2) 人間の生命・身体・財産、精神及び環境に配慮したリスク対策」のセクション内。

- 加筆内容: AI技術の急速な進化とそれに伴う新たなリスクに対応するための継続的な評価と更新プロセスの重要性を強調する記述を追加。

- 敵対的攻撃への対策:

- 加筆場所: 「P-5) セキュリティ対策のための仕組みの導入」のセクション内。

- 加筆内容: 生成AIに固有のセキュリティリスク、特に敵対的攻撃やデータポイズニングへの対応策に関する具体的なガイダンスを明確にする記述を追加。

- 説明責任と透明性の促進:

- 加筆場所: 「P-6) システムアーキテクチャ等の文書化」及び「P-6)ii. 関連するステークホルダーへの情報提供」のセクション。

- 加筆内容: AIモデルの判断根拠や学習データの選択理由など、透明性を高めるための手法やプロセスに関する詳細なガイダンスを提供する記述を追加。

これらの加筆・訂正を行うことで、本編第4部はAI提供者が現代のAI技術のリスクやチャレンジに対応するためのより具体的かつ実用的なガイダンスを提供できるようになります。

私#22:

他に、何か追記すべきことはありますか?

ChatGPT-4#22:

現在の情報に基づいて、本編第4部と別添第4部の内容に関して、特に生成AIに関する最新の動向や課題に対応するための追記や修正を提案する場合、以下の点を考慮すると良いでしょう:

- 持続可能性と倫理的使用:AIシステムの開発と提供において、環境への影響や倫理的使用に関する考慮がますます重要になっています。これらの側面に関するガイダンスを明確にすることで、AI提供者が社会的責任を果たす上での指針を提供することができます。

- 多様性と包括性:AI開発と提供のプロセスにおける多様性と包括性の促進は、バイアスの軽減や公平性の向上に寄与します。特に、異なる背景を持つ人々からのフィードバックや参加を促進する方法についてのガイダンスを加えることが有効です。

- 国際的な協力と標準化:AI技術のグローバルな影響を考慮し、国際的な協力や標準化への取り組みについての記述を加えることで、AI提供者が世界的な枠組み内での協力や規制へ適応するための指針を提供できます。

これらの追記や修正を行うことで、文書はAI提供者が直面する現代の課題や技術的進歩に対応するためのより包括的なガイドラインとなります。

私#23:

例えば、現在ChatGPTを使いたい場合、OpenAI社のクラウドも使えますが、Microsoft AzureのOpenAIサービス経由でも使えます。そして、Azure経由でChatGPTを使う場合、第4部のAI 提供者にとって、重要な事項の大部分は、Azure側で配慮されていれば、AI提供者はさほど気にしなくてもよい気がしますがいかがでしょうか?

ChatGPT-4#23:

その通りです。例えば、Microsoft AzureのOpenAIサービスを介してChatGPTを利用する場合、多くの重要な事項、特にセキュリティ、プライバシー保護、リスク管理などは、Azureのプラットフォームが提供する基盤とポリシーによってカバーされています。そのため、AIを提供する側(この場合はAzure経由でChatGPTを利用する企業や開発者)は、これらの基盤上でサービスを構築することで、直接的にこれらの問題に対処する負担が軽減されます。

ただし、最終的なAIサービスの提供者としては、利用者に対して明確なガイダンスや使用上の留意点を提供する責任があり、特にAIの出力に対する最終的な品質管理や利用目的に合致した適切な使用を保証するための措置は重要です。これには、AIサービスの特定の使用ケースにおける倫理的配慮や、特定のビジネスニーズに合わせたカスタマイズの適用などが含まれる場合があります。

私#24:

はい。ただ、Azureに限らず、AWSやGCPでも同じことがいえるので、このようなAIシステム構築プラットフォーマーの開発・実行環境を利用することによって、AI提供者の負荷が軽減されることを提案事項として追加したいのですが、第4部のどこにどういう形で追加できるでしょうか?

ChatGPT-4#24:

このような提案を第4部に反映させる場合、「AIシステム実装時」と「AIシステム・サービス提供後」のセクションに加えることが適切です。特に、AI提供者がクラウドサービスプロバイダー(例:Azure, AWS, GCP)の開発・実行環境を利用することによる利点と責任の範囲について説明し、AI提供者が直面する負荷の軽減とそれに伴うリスク管理やセキュリティ対策におけるクラウドサービスプロバイダーの役割を強調する内容を追加します。具体的には、AI提供者に求められるリスク対策やセキュリティ対策の一部が、これらのプラットフォームによって提供されるサービスの一部として既にカバーされていることを指摘し、AI提供者はプラットフォームのガイドラインやベストプラクティスに従うことで、より効率的かつ効果的にAIシステムを提供できることを明記する形が良いでしょう。

私#25:

AI提供者としては、今後、GPTストアのようなサイトから入手したカスタムGPTを利用したAIシステム開発も増えると思いますが、その場合に注意すべきことも指摘したいですね。

ChatGPT-4#25:

AI提供者がGPTストアのようなサイトからカスタムGPTを利用したAIシステムを開発する際には、特にセキュリティ、信頼性、透明性に関する注意が必要です。カスタムモデルの出所、品質、使用に関するライセンス条件を確認し、提供されるモデルが自社の倫理基準や法令遵守の要件を満たしていることを保証することが重要です。このような点に注意することを、本編第4部「AI提供者にとって重要な事項」のセクション内に追加することで、AI提供者が外部から提供されるAIモデルを使用する際のリスクを軽減し、より安全で信頼性の高いAIシステム・サービスを提供できるように指導する内容を反映させることができます。

私#26:

具体的には、「AI システム実装時」のどこへの追記が適切でしょうか?

ChatGPT-4#26:

「AI システム実装時」セクションにおける「P-2)i. 人間の生命・身体・財産、精神及び環境に配慮したリスク対策」と「P-3)i. AI システム・サービスの構成やデータに含まれるバイアスへの配慮」の間、またはこれらのセクションの直後に追記するのが適切です。ここに、外部から入手したカスタムGPTを利用する際のセキュリティ確保、信頼性の検証、透明性の確保に関する具体的なガイドラインを加えることが推奨されます。この追記により、AI提供者がカスタムモデルの選定と利用における潜在的なリスクを認識し、適切な対策を講じることの重要性が強調されます。

私#27:

では、最後に本編第5部と別添の該当する部分をアップします。

ChatGPT-4#27:

Please go ahead and upload the documents for the fifth part of the main text and the corresponding section in the annex, and I’ll assist with the review.

私#28:

<本編第5部と別添第5部のpdfをアップロード>

本編第5部と、別添第5部の資料をアップしたので、①まず、それぞれの内容を要約し、②本編と別添資料の対応関係を確認し、③両者の資料の一貫性と矛盾の検証を行い、④ChatGPTのような生成AIの観点から、2つの資料に関して加筆・訂正すべき点があれば、該当箇所を指摘の上、意見をまとめ、回答を、①、②、③、④のタスクに分けて日本語で示してください。

ChatGPT-4#28:

① 要約

- 本編第5部では、AI利用者が安全で信頼できるAIシステム・サービスを提供者から受け、適切に利用及び運用することの重要性を強調しています。具体的な重要事項として、安全性、公平性、プライバシー保護、セキュリティ対策などが挙げられています。

- 別添第5部では、本編第5部で挙げられたAI利用者のための指針に基づき、安全な利用、バイアスの配慮、個人情報の保護、セキュリティ対策、ステークホルダーへの情報提供など、具体的な手法や考慮すべき点を詳細に解説しています。

② 本編と別添資料の対応関係

- 本編第5部と別添第5部は直接対応しており、本編で提起されたAI利用者のための重要事項に対して、別添ではそれらを実践するための具体的な手法が示されています。

③ 一貫性と矛盾の検証

- 両文書は一貫しており、本編で挙げられた指針や重要事項に対して、別添で具体的な実践方法や考慮すべき点を補足しています。矛盾する内容は見受けられません。

④ 加筆・訂正すべき点

- 生成AIの観点から、AI利用者によるデータの扱いや入力、AIシステムの理解と適切な使用に関する教育・リテラシーの重要性が強調されるべきです。具体的には、AIが生成する情報の解釈や、その情報を基にした意思決定プロセスにおける人間の役割の明確化、AI技術の進展に伴う新たなリスクや倫理的な問題への対応策など、AI利用者が知っておくべき新たな情報やガイドラインの追加が考えられます。

私#29:

具体的には、本編第5部のどこへの追記が適切でしょうか?

ChatGPT-4#29:

追記は、「U-2)i. 安全を考慮した適正利用」や「U-3)i. 入力データ、プロンプトに含まれるバイアスへの配慮」のセクションに適切でしょう。ここに、生成AIの使用における新たなリスクや課題に対応するためのガイダンスを追加することで、AI利用者が生成AIをより安全に、かつ倫理的に使用するための具体的な方法を理解できるようになります。また、AIの出力の解釈や、AIによる意思決定の補助における人間の役割の重要性を強調する内容を含めることが有益です。これにより、AI利用者はAI技術の進歩と共に生じる可能性のある新たな課題に効果的に対応できるようになります。

私#30:

それぞれへの具体的な加筆訂正の文章を示してください。

ChatGPT-4#30:

具体的な加筆・訂正の提案は以下の通りです:

「U-2)i. 安全を考慮した適正利用」への追記

「AIシステムの安全な利用には、特に生成AIにおける最新の技術的進展とそれに伴うリスクを理解し、適応することが不可欠です。利用者は、生成AIが提供する出力の信頼性と限界を認識し、精度やリスクの程度を慎重に評価した上で、責任ある判断を行うべきです。」

「U-3)i. 入力データ、プロンプトに含まれるバイアスへの配慮」への追記

「生成AIの利用において、入力データやプロンプトに含まれるバイアスに対する配慮は特に重要です。公平性が担保されたデータの選択と、偏見のないプロンプトの設計を通じて、AIが公正な出力結果を提供するよう努めるべきです。さらに、AIの出力結果に対する定期的な監視と評価を行い、必要に応じて調整を加えることで、バイアスの影響を最小限に抑えることが期待されます。」

これらの追記は、AI利用者が生成AIを安全かつ公平に使用するための具体的な行動指針を提供し、AI技術の責任ある利用を促進することを目的としています。

今回は、ChatGPT-4との対話を通して、パブリックコメントを作成する模様をご覧いただきました。

なお、このChatGPT-4との対話の内容をベースに、「AI事業ガイドライン案」に関するe-Gov パブリックコメントのページから、合計10件の意見を提出しました。

本日は以上です。

終わり

- 投稿タグ

- AI事業者ガイドライン, パブリックコメント